python编程输出如下图案,上图为题目要求,下图为我写的。。。求指导!!!a=''#a初始化的时候应该是空字符串,这样加b就是一个星号

b='*'

foriinrange(7):

a=a+b

printa如果解决了您的

使用jieba.lcut()对下面的文本进行分词处理,输出结果。

python3怎么使用结巴分词

下面这个程序是对一个文本文件里的内容进行分词的程序:test.py

[python] view plain copy

#!/usr/bin/python

#-*-encoding:utf-8-*-

importjieba#导入jieba模块

defsplitSentence(inputFile,outputFile):

fin=open(inputFile,'r')#以读的方式打开文件

fout=open(outputFile,'w')#以写得方式打开文件

foreachLineinfin:

line=eachLine.strip().decode('utf-8','ignore')#去除每行首尾可能出现的空格,并转为Unicode进行处理

wordList=list(jieba.cut(line))#用结巴分词,对每行内容进行分词

outStr=''

forwordinwordList:

outStr+=word

outStr+='/'

fout.write(outStr.strip().encode('utf-8')+'\n')#将分词好的结果写入到输出文件

fin.close()

fout.close()

splitSentence('myInput.txt','myOutput.txt')

写完程序之后,在Linux重点输入:python test.py即可运行程序进行分词。

输入的文件内容如下所示:

经过结巴分词后,输出结果如下所示:

注意:第11行的 jieba.cut()返回的结构是一个可迭代的generator,可以用list(jieba.cut(...))转化为list

如何用python和jieba分词,统计词频?

#!python3

#-*-coding:utf-8-*-

importos,codecs

importjieba

fromcollectionsimportCounter

defget_words(txt):

seg_list=jieba.cut(txt)

c=Counter()

forxinseg_list:

iflen(x)>1andx!='\r\n':

c[x]+=1

print('常用词频度统计结果')

for(k,v)inc.most_common(100):

print('%s%s%s%d'%(''*(5-len(k)),k,'*'*int(v/3),v))

if__name__=='__main__':

withcodecs.open('19d.txt','r','utf8')asf:

txt=f.read()

get_words(txt)

Python作业求助

就做一下标点符号的替换吧

txt=open("绝代风华.txt","r+",encoding='utf-8').read()#修改访问模式为"r+"

txt2=txt.replace(",",'').replace("。",'')#还有什么符号就自己加吧

txt3=open("E://绝代风华2.txt","w+",encoding='utf-8')#设置路径比较好,在文件名前加

txt3.write(txt2)#写入替换好的文本,形成新文本

#以下三句放在代码的后面

txt.close()

txt3.close()

#打开新文本,若查看的文本内容无误,这两行代码可以注释。

pl=open("E://绝代风华2.txt","r",encoding='utf-8').read()

pl.close()如何利用Python对中文进行分词处理

python做中文分词处理主要有以下几种:结巴分词、NLTK、THULAC 1、fxsjy/jieba 结巴的标语是:做最好的 Python 中文分词组件,或许从现在来看它没做到最好,但是已经做到了使用的人最多。结巴分词网上的学习资料和使用案例比较多,上手相对比较轻松,速度也比较快。 结巴的优点: 支持三种分词模式 支持繁体分词 支持自定义词典 MIT 授权协议 2、THULAC:一个高效的中文词法分析工具包 前两天我在做有关于共享单车的用户反馈分类,使用jieba分词一直太过零散,分类分不好。后来江兄给我推荐了THULAC: 由清华大学自然语言处理与社会人文计算实验室研制推出的一套中文词法分python中怎样处理汉语的同义词用结巴分词

python中文分词:结巴分词 中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词。其基本实现原理有三点: 基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG) 采用了动态规划查找最大概率路径, 找出基于词频的最大切分组合 对于未登录词,采用了基于汉字成词能力的HMM模型,使用了Viterbi算法 安装(Linux环境) 下载工具包,解压后进入目录下,运行:python setup.py install 模式 默认模式,试图将句子最精确地切开,适合文本分析 全模式,把句子中所有的可以成词的词语都扫描出来,适合搜索引擎 接口 组件只提供j相关文章

-

Python中使用“*”星号输出空心正详细阅读

-

python安装easycython之后调用不了详细阅读

python easy install不是内部或外部命令,也不是可执行的程序 环境变量已经设置正确了easy_install是Python在新版本中增加的setup工具,可以自动从网上下载安装包进行自动化安

-

python如何下载详细阅读

如何下载并安装python?1、首先,需要到python的官方网站下载python的安装包。python官网的链接地址:https://www.python.org。

2、打开官方网站,光标移到Downloads,选择windows。 -

为什么python中运行代码python -m详细阅读

我的这个python文件有什么错误吗?为什么提示invalid syntax错误?python提示错误invalid syntax时因为:Python 2.x升级到Python 3.x,print函数的语法变化了,所以用Python 2.x的pr

-

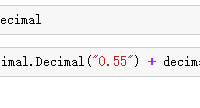

python计算360.65+239.2为什么会出详细阅读

自己写了一个python加减乘除运算,不知道为啥会出错您好!请记住,计算表达式中只有(),不会有 [][] 指的是 list 列表,您把列表和浮点数混在一起计算,自然会报错请采纳哦~在Python2.7中

-

移动云函数计算支持Python2.7/3.6详细阅读

python3.6和python2.7的区别Python2.x与3.x版本区别Python的3.0版本,常被称为Python 3000,或简称Py3k。相对于Python的早期版本,这是一个较大的升级。为了不带入过多的累赘,Pyth

-

Python报错详细阅读

如何解决python安装启动报错解决python安装启动报错的方法:

打开系统的环境变量path,将python的安装路径添加进去,然后确定,重新启动python就可以了示例如下:更多Python知识,请关 -

信息技术会考操作题photon已经做完详细阅读

信息技术学业水平考试步骤错了会不会影响成绩?不会,这种考试一是看你的最终结果,最终结果相同应该就能获得分数,步骤错了也分步骤顺序错了和步骤的具体操作错了,顺序错了不会有影

-

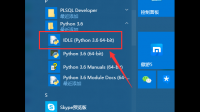

python gui界面怎么改成中文界面详细阅读

python idle怎么调成中文版1、首先点击电脑上的开始菜单,在开始菜单中安装的python目录下点击‘IDLE(Python 3.6 64-bit),进入IDLE。2、然后在打开的页面,可以看到默认字体大小

-

怎么安装Python?详细阅读

Python如何安装?Python3 下载 Python3 最新源码,二进制文档,新闻资讯等可以在 Python 的官网查看到: Python 官网:https://www.python.org/ 你可以在以下链接中下载 Python 的文