北京博华科技有限公司怎么样北京博华科技有限公司是很不错的 北京博华信智科技股份有限公司(简称博华科技),成立于2006年,主要从事工业互联网、工业AI装备状态监测、健康管理,服

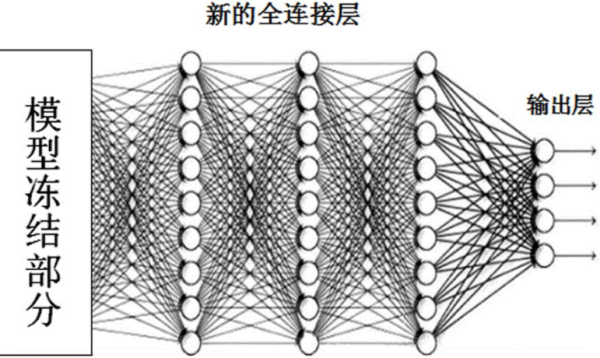

如何得到全连接层的输出(没有经过softmax)

线性层和全连接层的区别

线性层和全连接层没有区别。线性层即全连接层。

全连接层,是每一个结点都与上一层的所有结点相连,用来把前边提取到的特征综合起来。由于其全相连的特性,一般全连接层的参数也是最多的。

例如在VGG16中,第一个全连接层FC1有4096个节点,上一层POOL2是7*7*512 = 25088个节点,则该传输需要4096*25088个权值,需要耗很大的内存。

卷积神经网络的全连接层

在 CNN 结构中,经多个卷积层和池化层后,连接着1个或1个以上的全连接层。与 MLP 类似,全连接层中的每个神经元与其前一层的所有神经元进行全连接。全连接层可以整合卷积层或者池化层中具有类别区分性的局部信息。为了提升 CNN 网络性能,全连接层每个神经元的激励函数一般采用 ReLU 函数。

最后一层全连接层的输出值被传递给一个输出,可以采用 softmax 逻辑回归(softmax regression)进行分类,该层也可称为 softmax 层(softmax layer)。对于一个具体的分类任务,选择一个合适的损失函数是十分重要的,CNN 有几种常用的损失函数,各自都有不同的特点。通常,CNN 的全连接层与 MLP 结构一样,CNN 的训练算法也多采用BP算法。

为什么RCNN用SVM做分类而不直接用CNN全连接之后softmax输出

在多分类中,CNN的输出层一般都是Softmax。 RBF在接触中如果没有特殊情况应该是“径向基函数”(RadialBasisFunction)。 在DNN兴起之前,RBF由于出色的局部近似能力,被广泛应用在SVM的核函数中,当然也有熟悉的RBF神经网络(也就是以RBF函数为激活函数的单隐含层神经网络)。 如果说把RBF作为卷积神经网络的输出,觉得如果不是有特殊的应用背景,它并不是一个很好的选择。 至少从概率角度上讲,RBF没有Softmax那样拥有良好的概率特性。CNN中卷积层、池化层和全连接层分别有什么作用和区别?

如下:

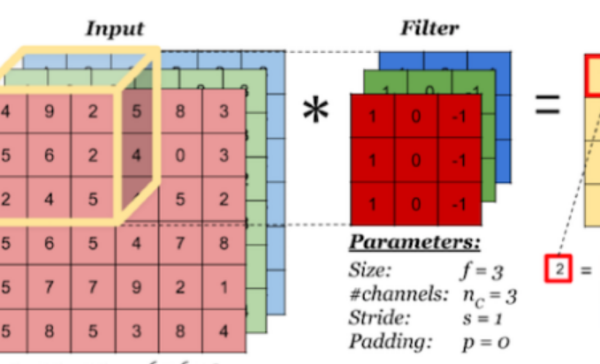

卷积层:提取特征。“不全连接,参数共享”的特点大大降低了网络参数,保证了网络的稀疏性,防止过拟合。之所以可以“参数共享”,是因为样本存在局部相关的特性。

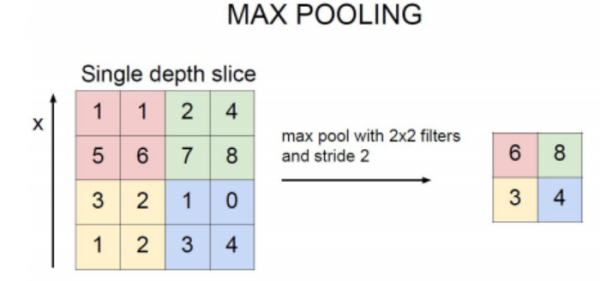

池化层:有MaxPool和AveragePool等。其中MaxPool应用广泛。因为经过MaxPool可以减小卷积核的尺寸,同时又可以保留相应特征,所以主要用来降维。

全连接层:在全连接的过程中丢失位置信息,可以理解为降低了学习过程中的参数敏感度;很多分类问题需要通过softmax层进行输出;进行非线性变换等等。但是现在已经有很多网络结构去掉了最后的全连接层。我也是入坑没多久,对这一点理解仍很粗浅。

深度网络中为何引入池化层?

减少大量的计算量。引入空间过滤器的层级结构,从而让连续卷积层的观察窗口变大,这样可以更加充分地获得信息。

池化(Pooling):也称为欠采样或下采样。主要用于特征降维,压缩数据和参数的数量,减小过拟合,同时提高模型的容错性。主要有:

Max Pooling:最大池化

Average Pooling:平均池化

Max Pooling:选取最大的,我们定义一个空间邻域(比如,2*2的窗口),并从窗口内的修正特征图中取出最大的元素,最大池化被证明效果更好一些。

Average Pooling:平均的,我们定义一个空间邻域(比如,2*2的窗口),并从窗口内的修正特征图中算出平均值。

输出层(全连接层)

经过前面若干次卷积+激励+池化后,终于来到了输出层,模型会将学到的一个高质量的特征图片全连接层。其实在全连接层之前,如果神经元数目过大,学习能力强,有可能出现过拟合。因此,可以引入dropout操作,来随机删除神经网络中的部分神经元,来解决此问题。还可以进行局部归一化(LRN)、数据增强等操作,来增加鲁棒性。

当来到了全连接层之后,可以理解为一个简单的多分类神经网络(如:BP神经网络),通过softmax函数得到最终的输出。整个模型训练完毕。

怎样用python构建一个卷积神经网络

用keras框架较为方便

首先安装anaconda,然后通过pip安装keras

以下转自wphh的博客。

#coding:utf-8

'''

GPUruncommand:

THEANO_FLAGS=mode=FAST_RUN,device=gpu,floatX=float32pythoncnn.py

CPUruncommand:

pythoncnn.py

2016.06.06更新:

这份代码是keras开发初期写的,当时keras还没有现在这么流行,文档也还没那么丰富,所以我当时写了一些简单的教程。

现在keras的API也发生了一些的变化,建议及推荐直接上keras.io看更加详细的教程。

'''

#导入各种用到的模块组件

from__future__importabsolute_import

from__future__importprint_function

fromkeras.preprocessing.imageimportImageDataGenerator

fromkeras.modelsimportSequential

fromkeras.layers.coreimportDense,Dropout,Activation,Flatten

fromkeras.layers.advanced_activationsimportPReLU

fromkeras.layers.convolutionalimportConvolution2D,MaxPooling2D

fromkeras.optimizersimportSGD,Adadelta,Adagrad

fromkeras.utilsimportnp_utils,generic_utils

fromsix.movesimportrange

fromdataimportload_data

importrandom

importnumpyasnp

np.random.seed(1024)#forreproducibility

#加载数据

data,label=load_data()

#打乱数据

index=[iforiinrange(len(data))]

random.shuffle(index)

data=data[index]

label=label[index]

print(data.shape[0],'samples')

#label为0~9共10个类别,keras要求格式为binaryclassmatrices,转化一下,直接调用keras提供的这个函数

label=np_utils.to_categorical(label,10)

相关文章

- 详细阅读

局域网内如何提高网速加大内存就可以了, 再好点的办法就是装双网卡!! 就是集成的一个,再加一个跟集成的一样的的网卡! 自动的!!很快!!枪死你的色友关于局域网的网速问题首先我先解释

怎么修改wifi密码?修改无线连接密码步骤(以tplink路由器为例)1、路由器和电脑连接,打开浏览器,在地址栏输入192.168.1.1(一般路由器地址是这个或者查看路由器背面的登录信息)进路

手持VH501TC混合传感器信号采集读数仪新增多种型号怎么了解区分?VH501TC基础款:就是我们平时说的丐中丐版,虽然是丐版,但功能可不少,支持振弦频率,温度传感器读取与存储,使用可更换

5G的到来,会有哪些实质性的改变,对互联网行业会哪些影响?2019年中国5G产业市场分析:开启产业互联网新阶段,全球化步伐有待加快5G板块热度不减 开启产业互联网新阶段近期,5G板块热

在上海,想办好用网速快的宽带,有推荐吗?推荐您办理电信宽带使用,电信宽带套餐多资费优惠,而且中国电信的宽带信号稳定,网络速度快。 由于中国电信的服务器、网络架设等较完善,且每

- 详细阅读

NHR-6300“傻瓜式”液晶人工智能温控器的记录时间是多长?6300“傻瓜式”液晶人工智能温控器记录时间的长度和记录间隔有关系,记录间隔是1S的时候,记录时长是3天;间隔2S的记录时

宽带错误629:连接被远程计算机终止什么意思?错误629:端口已由远程计算机断开连接,为电脑中错误代码629。The port was disconnected by the remote machine. 该端口不能被远程计

wifi上有个感叹号怎么解决解决方法如下:1、鼠标右键点击wifi标志,点击打开网络和共享中心,再点击更改适配器设置。(或者通过控制面板-网络和intenet-网络和共享中心)2、进入后,右